将DataHub作为目标端

更新时间:2025-08-21

前置工作

- 在资源账户下拥有DataHub实例。(详情见 DataHub操作指南)

配置任务

- 进入DTS控制台界面

- 点击 创建数据传输任务

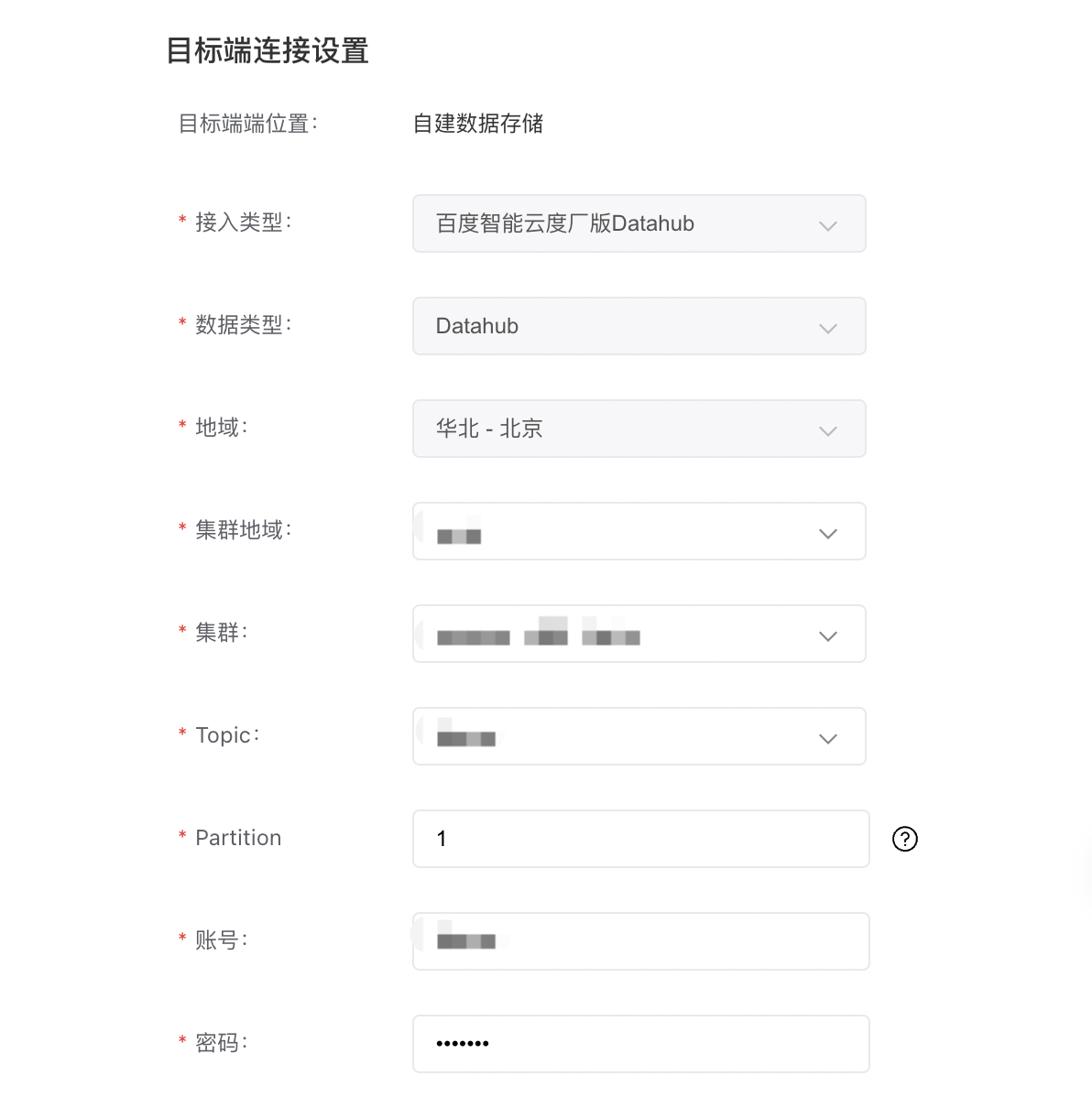

- 选择目标端位置为自建数据存储,目标端接入类型为百度智能云度厂版Datahub,目标端数据类型为Datahub,按需选择地域

- 按需选择源端,点击下一步,确认订单

- 创建完成后,在列表操作列点击配置任务进行配置,根据DataHub实例信息,填写目标端配置(集群地域、集群、topic 等)如下图所示

DataHub的账号密码需要填写创建Topic对应的账号(可在DataHub-Topic管理里看到对应的账号,如下图所示),否则会因为没有写权限而造成任务失败

- 当目标端为DataHub时,不支持结构迁移

消息格式

Plain Text

1//json结构

2[ //最外层是数组

3{ //第一行记录,一条message可能包含1到多行记录

4 "TIME":"20180831165311", //时间戳

5 "GLOBAL_ID":"xxxxxxxx", //全局唯一ID,消费者可用此ID来去重

6 "DATABASE":"db1", //数据库名

7 "SCHEMA":"schema1", //SCHEMA名,仅在上游为PostgreSQL、SQLServer时存在

8 "TABLE":"tbl1", //表名

9 "TYPE":"U", //变更类型,I为insert,U为update,D为delete

10 "LOGICAL_CLOCK":"1617327447310000011", //逻辑时钟,用于批处理时判断消息先后顺序

11 "OLD_VALUES":{ //变更前每列的”列名”:”列值”组,变更类型为I时无OLD_VALUES

12 "key1":"old-value1",

13 "key2":"old-value2",

14 ...

15 },

16 "NEW_VALUES":{ //变更后每列的”列名”:”列值”组,变更类型为D时无NEW_VALUES

17 "key1":"new-value1",

18 "key2":"new-value2",

19 ...

20 },

21 "OFFSET":{ //该条记录的位置信息,仅在上游为MySQL时的增量迁移阶段有值,对消费者无用

22 "BINLOG_NAME":"mysql-bin.xxx",

23 "BINLOG_POS":"xxx",

24 "GTID":"server_id:transaction_id" //仅在使用GTID方式同步时存在

25 }

26},

27{ //第二行记录

28 "TIME":"20180831165311",

29 "DATABASE":"db1",

30 ...

31}

32... //更多行记录

33]